Quelle empreinte écologique pour l’informatique ? Le point sur les data centers (ou centres de données), qui ont gagné en efficience ces dernières années. Mais des pratiques comme le streaming ont un impact global considérable.

Prenons l’exemple de Google, qui indexe des millions de documents pour faciliter et accélérer la recherche. Ces données sont aussi analysées pour pouvoir proposer aux utilisateurs des contenus publicitaires : c’est sur cette approche que repose son modèle économique. Or, pour réaliser ces traitements, on estime que Google possède plus d’un million de serveurs, comme les trois autres géants du Web que sont Amazon, Microsoft et Facebook. Qu’elles possèdent leurs propres infrastructures ou qu’elles les louent, les entreprises et les institutions plus modestes font souvent appel à des milliers d’équipements interconnectés, depuis la capture de données jusqu’à leur analyse.

Les data centers, ces usines de la donnée qui abritent des milliers de serveurs informatiques, sont-ils des gouffres énergétiques ? Le numérique, qui a pris une place inédite dans nos vies, a lui aussi une empreinte écologique. Dans son ensemble, le secteur du numérique engloutissait près de 10% de la production électrique mondiale en 2015. Les data centers en accaparent 18%, selon une synthèse publiée fin 2017 par l’association négaWatt et reprise par le site GreenIT. À quoi servent ces centres de données et que penser de leur consommation d’énergie ? Le récapitulatif de Sciences et Avenir.

Cloud et data centers, ou l’informatique dans les nuages

Derrière la terminologie de « data center » (ou centre de données dans la langue de Molière) se cache en réalité un lieu physique (pièce, voire bâtiment) regroupant des serveurs informatiques, jusqu’à à plusieurs milliers. Qu’est-ce qu’un serveur ? Il s’agit d’un ordinateur mis en réseau (souvent directement sur internet) pour héberger des données. Il y a 10 ou 20 ans, ces serveurs étaient localisés directement dans les locaux des entreprises qui en avaient besoin, tandis que la plupart des particuliers stockaient leur données sur leur micro-ordinateur, en local. Avec le cloud, tout a changé : on peut accéder à ses fichiers où que l’on soit. Par exemple, avec Google Drive, depuis son domicile, son lieu de travail, son smartphone… Siri, Google Home ou Alexa, fonctionnent également dans le cloud : ils doivent se connecter à des serveurs distants sur internet pour fonctionner !

CLOUD. La révolution numérique est passée par là, entraînant dans son sillage de nouvelles pratiques, dont celle du cloud computing (ou « informatique dématérialisée »). D’ici 2021, la capacité de stockage des data centers devrait encore être multiplié par 4, selon une étude de Cisco. En fait, le stockage des données est dans ce cas externalisé par des sociétés spécialisées, qui se chargent de ses aspects opérationnels et matériels. De quoi faciliter l’administration des serveurs, en les confiant à des professionnels…. et surtout réduire les durées d’interruption lorsque des pannes se produisent. Le numérique pesant désormais lourdement dans l’économie, on comprend qu’un site de e-commerce (par exemple) souhaite réduire au plus bas la durée où ses pages sont inaccessibles.

Récupérer la chaleur des data centers

En France, la consommation des data centers s’élevait à environ 3 TWh en 2015, soit davantage que la consommation électrique de la ville de Lyon, selon l’Union française de l’électricité (UFE). À quoi tient-elle ? Il faut bien entendu alimenter en électricité les nombreux appareils. Mais elle est principalement dissipée sous forme de chaleur lorsqu’elle passe dans un matériau conducteur, ce qu’on appelle « effet joule ». De ce fait, environ 50% de la facture d’électricité d’un data center... tient à la climatisation, comme l’expliquaient nos confrères de Actu-Environnement. Pour réduire leurs coûts, les data centers ont alors tout intérêt à maximiser le « free cooling », ou refroidissement naturel en utilisant l’air frais extérieur. C’est pour cette raison que des géants comme Facebook (par exemple) ont délocalisé leurs serveurs dans des pays nordiques comme la Suède.

CHAUFFAGE URBAIN. Sous nos latitudes, on peut toutefois récupérer la chaleur produite afin de la valoriser. C’est déjà le cas : chauffage urbain (quartier d’affaires de Val d’Europe, chauffage d’une piscine publique parisienne, voire même une résidence étudiante à Grenoble ! Une limite technique toutefois : la température est trop basse (environ 25 à 50°) pour être compatible avec les réseaux de chaleur traditionnels, qui fonctionnent traditionnellement à une température supérieure à 60°. La solution : des réseaux basse température, développés pour cet usage spécifique.

L’équivalent d’une petite centrale… pour la seule vidéo « Gangnam Style » !

Gain de performance, valorisation de la chaleur… les data centers méritent-ils encore leur réputation d’ogres numériques ? Le rapport de négaWatt ne détaillait pas seulement la consommation des serveurs, mais également celle des terminaux (ordinateurs, téléphones, tablettes..) et celle du réseau (lignes ADSL, mais aussi WIFI, 3G, 4G…), comme le montre le graphe ci-dessous. Verdict : en 2015, les terminaux consommaient déjà 2 fois plus que les serveurs et centres de données. Et alors que ces derniers gagnent en efficacité, l’électricité consommée par le « dernier kilomètre numérique » explose : la 4G consommerait jusqu’à 23 fois plus que le WIFI.

L’impact spatial et énergétique des data centers sur les territoires

Microsoft installe un data-center sous la mer

VIDÉO L’eau est censée refroidir naturellement l’infrastructure.

l fait 12,2 m de long et comprend 864 serveurs. Le nouveau data-center de Microsoft est certes petit mais il a une originalité. Il a été installé trois mètres sous la surface de la mer, au large des côtes écossaises, en témoigne une vidéo publiée par le groupe sur Internet mardi 5 juin. L’entreprise se donne un an pour tester cette installation aux nombreux avantages, baptisée « projet Natick ».

IMPACT INDIVIDUEL. Que faire à son propre niveau ? Afin d’éviter de saturer les serveurs distants : supprimer ses vieux courriels (et surtout ceux contenant de volumineuses pièces jointes), ou encore limiter son utilisation des services de streaming en ligne (Youtube, Deezer, Netflix…). « Une vidéo comme Gangnam Style, visionnée 2,7 milliards de fois sur la planète, a consommé l’équivalent de la production annuelle d’une petite centrale », expliquait en 2017 Gary Cook, analyste pour l’ONG Greenpeace, dans Le Parisien.

France tv éducation le 5 avr. 2018

Difficile aujourd’hui de se passer d’Internet tant son usage s’est répandu dans tous les pans de notre vie quotidienne. Or, si cette technologie virtuelle nous permet notamment de communiquer sans nous déplacer et de gaspiller moins de papier, son impact écologique est bien réel. D’autant plus que pour accéder à ce monde immatériel, les consommateurs multiplient des équipements gourmands en énergie et en matières premières. D’une durée de vie limitée, ces ordinateurs, smartphones et tablettes numériques, finissent dans des poubelles déjà surchargées.

Emails, réseaux sociaux, recherches d’informations, achats dématérialisés, séries en streaming, archivage de photos sur le cloud, jeux vidéo et musique en ligne… : de « Big », le Data est devenu géant ! La preuve par ces chiffres vertigineux : selon l’Agence de l’Environnement et de la Maitrise de l’Energie, dans le monde, en 1 heure, 8 à 10 milliards d’emails sont échangés, et 180 millions de recherches sont effectuées sur Google. Au total, le secteur informatique représente aujourd’hui 7 % de la consommation mondiale d’électricité. Si Internet était un pays, il serait le troisième plus grand consommateur au monde après la Chine et les Etats-Unis, et avant la Russie.

La pollution invisible générée par l’industrie du net et son impact sur le climat équivaudrait à celle du secteur de l’aviation. Or, le nombre d’utilisateurs ne cesse de croître : de trois milliards aujourd’hui, il devrait passer à plus de quatre milliards d’ici à la fin de la décennie. Mais que se cache-t-il derrière la Toile au fonctionnement si obscur ? Les émissions de gaz à effet de serre générés par la galaxie numérique se répartissent ainsi : 47 % de ces émissions sont dues aux équipements des consommateurs du fait de la fabrication du matériel et de la dépense d’électricité. 28 % aux infrastructures réseau. Enfin, 25 % aux centres de traitement des données, les data centers qui traitent et stockent toutes nos données. Heureusement, un autre internet est possible !

Un data center écologique a par exemple été implanté en Norvège : ses salles de serveur informatique sont refroidies, non plus à partir d’énergies polluantes comme le gaz et le charbon, mais via l’énergie hydraulique, et à la température polaire. On peut aussi limiter les rejets de CO2 dans l’air en recyclant la chaleur produite par les data centers pour chauffer des immeubles ou des piscines publiques par exemple. A notre petite échelle, nous pouvons nous aussi agir. Il suffit de vider régulièrement la corbeille de sa boîte mails, d’installer un anti-spams, de compresser ses fichiers joints, de télécharger une vidéo au lieu de la regarder en streaming, ou encore, pour éviter de faire une recherche énergivore, d’enregistrer comme favoris les sites sur lesquels vous surfez souvent, comme celui de francetv éducation ! France tv éducation

Mardi 15 janvier était inauguré le tout dernier datacenter mis en service dans notre pays : il s’agit de ROCK, construit dans le 8ème arrondissement de Lyon par DCforData, désormais filiale de Jaguar Network, lui-même racheté par Iliad / Free.

Le dernier datacenter construit en France par DCforData / Jaguar Network, à Lyon Voir Article

Internet et pollution : « Avec le numérique, on consomme de plus en plus d’énergie »

Décryptage avec Tilman Santarius, professeur à l’Université technique de Berlin.

D’après le CNRS, jusqu’à 10 % de la facture d’électricité mondiale, avec une tendance à la hausse puisqu’elle pourrait atteindre 21 % en 2030. 1 % de la consommation d’électricité en France est même due aux box Internet.

On dénombre 4 438 centres de données dans le monde dont 153 en France, d’après le site danois datacentermap.com. Facebook possède, à lui seul, 15 data centers, Google en a 15 également et Amazon 61. Autant de chiffres qui donnent le vertige – et placent le numérique parmi le peloton de tête des pollueurs. Entretien avec Tilman Santarius, professeur à l’Université technique de Berlin.

Quelles sont les idées reçues sur la transition numérique ?

J’en vois trois. La première : nos interactions numériques se font sur des objets très petits, comme les smartphones. Beaucoup de gens pensent que cet environnement numérique est presque immatériel et qu’il consomme peu voire pas de ressources. En réalité, il y a d’énormes centres de données qui se multiplient pour satisfaire nos demandes croissantes. Ce sont des tonnes de matériel, des gigawatts d’énergie que nous ne voyons pas et que nous ne payons pas. Nous chargeons simplement notre portable.

Et les deux autres ?

La deuxième, c’est penser qu’on gagne du temps. Un message est très vite écrit et envoyé, mais on communique beaucoup plus. Notre vie sociale s’accélère et on tente de faire entrer le plus de choses possible en une journée. La dernière, est de penser qu’on est plus efficace grâce au numérique. C’est en partie vrai, mais le progrès technique a conduit à un changement de nos modes de consommation. Par exemple, en Allemagne, un vêtement sur deux achetés en ligne est retourné, avec toutes les pertes de temps et d’énergie que cela suppose.

Ce sentiment d’un monde numérique moins gourmand en énergie est donc faux ?

L’impression n’est pas fausse, mais dans le calcul, on s’en tient souvent au matériel. Bien sûr, les courriels font économiser du papier, tout comme les liseuses et les voitures en libre-service en ville peuvent remplacer l’achat d’une voiture. Mais il faut prendre en compte l’effet rebond.

Qu’est-ce que l’effet rebond ?

C’est quand l’efficacité technique nous conduit à consommer plus. Par exemple, regarder des vidéos en ligne nous fait gagner en matériel – plus besoin de presser un DVD – en temps, en énergie à se rendre au magasin et parfois en coûts : je n’ai plus à investir pour chaque film acheté, j’ai une offre à volonté en ligne que je trouve en quatre clics. Cela nous conduit à avoir une consommation de films en ligne beaucoup plus grande. Le streaming, comme d’autres activités en ligne, est consommé de manière exponentielle.

Êtes-vous optimiste pour le futur ?

La transition numérique permet de consommer de manière plus responsable et laisse le choix au consommateur là où il souhaite investir son argent. Après, je ne pense pas qu’on puisse tenir l’objectif de 1,5 °C des accords de Paris en plus d’ici à la fin du siècle. Mais – et plus on consomme, moins on pourra atteindre les 100 % d’électricité issue des énergies renouvelables

A l’intérieur d’un datacenter de Microsoft dédié à ses services de cloud computing

Microsoft ouvre quatre datacenters en France pour accélérer son cloud

Le géant américain du numérique Microsoft ouvre officiellement ses quatre datacenters en France. Un investissement qui vise à accélérer son cloud dans l’Hexagone en répondant aux préoccupations de localisation des données.

Après plusieurs semaines de tests auprès de milliers de clients, Microsoft ouvre officiellement, le 14 mars 2018, ses quatre datacenters en France : trois dans la région parisienne et un dans la région de Marseille. Le montant de l’investissement n’est pas dévoilé. Il s’inscrit dans un effort européen qui comprend l’expansion de son infrastructure en Allemagne et l’ouverture d’une région en Suisse.

Microsoft disposait déjà d’une infrastructure importante en Europe avec des sites en Allemagne, au Royaume-Uni, en Irlande et aux Pays-Bas. C’est à partir de ces datacenters que le géant américain du numérique livrait jusqu’ici ses services de cloud computing Azure (infrastructure à la demande), Office 365 (applications à la demande de communication et collaboration) et Dynamics 365 (applications à la demande de gestion d’entreprise) à ses clients français.

Le datacenter souterrain

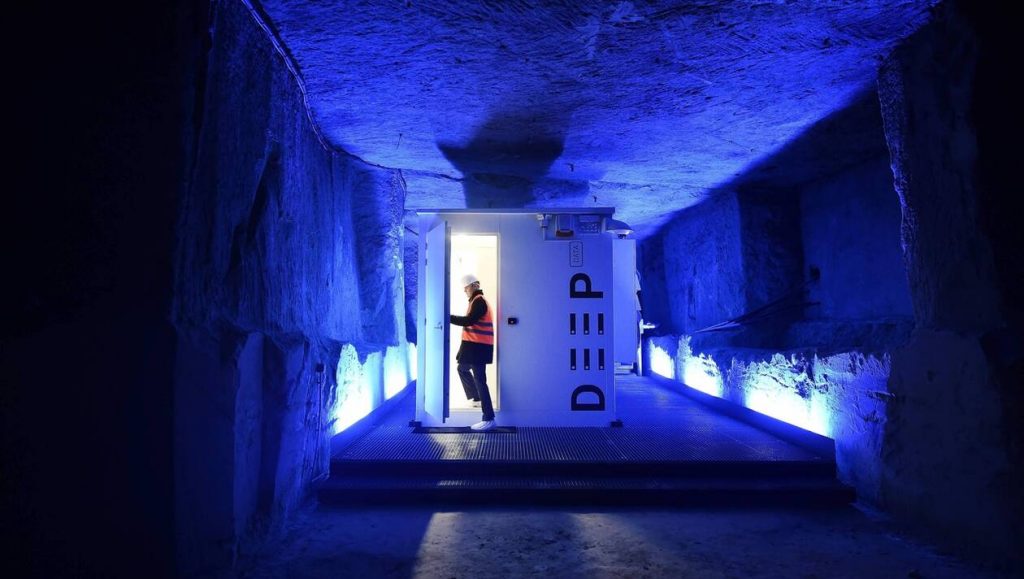

Enterré dans le sous-sol saumurois, ce centre de stockage de données numériques a déjà coûté 800 000 € d’argent public, sans créer d’emploi. Mais un client potentiel s’y intéresse de près.

Une insolite visite de presse se déroule, le 15 novembre 2016, dans un « troglo », une cave troglodytique située à quelques kilomètres de Fontevraud (Maine-et-Loire). Moyennant la promesse de ne pas divulguer l’adresse des lieux, les journalistes sont invités à découvrir un centre de stockage de données numériques unique en son genre.

La fraîcheur propice du sous-sol saumurois

Il est installé à quelque vingt ou trente mètres sous terre dans l’une de ces champignonnières, ou anciennes carrières de tuffeau, dont le sous-sol du Saumurois est criblé. Pourquoi là ? La température, explique-t-on aux reporters, y est opportunément basse et constante alors que« la climatisation, c’est la plus grosse partie de la facture des salles d’ordinateurs ». La fraîcheur naturelle de ces caves représente donc une belle économie doublée d’un avantage écologique. Le concept est original. Reste alors à séduire des clients.

Le projet « Monde souterrain »

Baptisé DeepData (« deep » comme profond), le projet est lancé en 2014 par la Région Pays de la Loire. Il est piloté par l’un de ses satellites, la Sopraf. L’une des sociétés publiques mises en place par le conseil régional pour exploiter l’abbaye de Fontevraud. En l’occurrence, la Sopraf accueille les touristes sur le site dont elle assure également l’entretien.

Mais quel rapport entre cette mission culturelle et l’économie numérique dont relève le deep data ? En fait, la Région charge en 2013 la Sofrap de trouver des perspectives de développement économique pour les caves du Saumurois. C’est le projet « Monde souterrain ». Il prévoit trois volets : l’ouverture d’espaces troglodytes au tourisme, la valorisation énergétique des galeries et le datacenter.

Le datacenter « Deep data », enterré dans le sous-sol de la région de Saumur. | AFP / JEAN-SÉBASTIEN EVRARD

« Pas de création d’emploi à ce jour »

Mais l’utilisation des deniers publics dans ce cadre est aujourd’hui sévèrement critiquée par la Chambre régionale des comptes (CRC), dans son récent rapport sur la gestion de la Sopraf de 2013 à 2017 : « Ce projet [«Monde souterrain »] aurait coûté plus d’un million d’euros, dont plus de 800 000 € de fonds publics », des dépenses portant « en quasi-totalité sur le datacenter ». Or, « aucun débouché économique n’est identifié » et « aucun partenaire privé ne souhaite à ce stade s’engager financièrement sur ce dossier ». En résumé, « pas de création d’emploi à ce jour, ni résultat économique probant. »

Le dossier recèle pourtant d’indéniables atouts. Les essais techniques sont « concluants »,reconnaît la CRC. Et le projet est désormais porté par un consortium réunissant la communauté d’agglomération du Saumurois (en remplacement de la Sopraf), la Caisse des dépôts et cinq sociétés spécialisées.

« Ça prend du temps, comme le bon vin »

Un contrat est d’ailleurs en discussion avec un tout premier client potentiel, comme l’a révélé récemment Le Courrier de l’Ouest. Un industriel français qui implanterait un site d’hébergement de données, avec cinq à quinze créations d’emplois. La signature pourrait intervenir au premier semestre 2019. Soit cinq ans après le lancement de DeepData.

Un délai qui, s’agissant d’innovation et d’élaboration d’un prototype, n’a rien d’excessif selon les porteurs du projet, qui en sont à présent à la phase de commercialisation : « Nous avons fait visiter le site à soixante-dix grands comptes. Et ça prend du temps », explique-t-on en coulisses, en ajoutant avec à-propos : « Un peu comme le bon vin. »

Dans son data center, Google doit conserver la trace de milliards de pages Web.

L’impact environnemental du data center : une responsabilité partagée

Les entreprises qui donnent la priorité à une stratégie de data center respectueuse de l’environnement seront les vrais gagnants sur le long terme, tant sur le plan commercial que sur celui du développement durable.

S’il est de leur responsabilité d’intégrer la dimension de développement durable à la performance et l’innovation dans leur sélection, les constructeurs doivent tout mettre en œuvre, depuis la conception, les matériaux, la production et le recyclage, et proposer les meilleures options afin de limiter l’impact environnemental de l’utilisation et de la puissance nécessairement croissantes des data.

Alors que la Journée de la Terre vient d’avoir lieu, le constat est clair : les coûts d’électricité croissants et les besoins en calcul figurent parmi les principales préoccupations du marché des data centers. D’après les estimations actuelles, les data centers installés aux États-Unis devraient consommer à eux seuls près de 73 milliards de KWh en 2020. En même temps, l’intelligence artificielle se développe de plus en plus et ces technologies exigent des équipements plus puissants pour absorber d’énormes charges de travail. L’efficacité des data centers et leur performance en matière de développement durable représentent un défi universel qui dépasse à la fois les entreprises, les régions du monde et les charges de travail. Il n’y a pas de solutions simples, mais les responsabilités doivent être partagées.

Alors que les data centers doivent répondre à des besoins de performance qui augmentent de façon exponentielle, leurs budgets d’exploitation restent les mêmes ou sont diminués. Les data centers doivent par conséquent offrir davantage de performance pour un budget énergétique inchangé. Alors que peut-on faire pour optimiser les budgets tout en limitant au maximum l’impact environnemental ?

Être des acheteurs et des producteurs conscients

Les Nations Unies estiment que le monde entier génèrera 50 millions de tonnes de déchets électroniques en 2018. Imaginez tous ces vieux équipements, baies de serveurs, câbles et ventilateurs qui deviennent des déchets. Œuvrer davantage pour l’environnement implique une certaine planification. Les entreprises qui donnent d’emblée la priorité à une stratégie de data center respectueuse de l’environnement seront à n’en pas douter les vrais gagnants sur le long terme – tant sur le plan commercial que celui du développement durable. Des choix judicieux doivent être faits lorsqu’il s’agit de sélectionner les matériaux et de créer les processus de production des systèmes. Tout doit être anticipé pour limiter l’impact environnemental, de la production à la capacité de réparer les produits plutôt que de les remplacer, en passant par le conditionnement.

Les équipes de développement devraient utiliser autant que possible des plastiques recyclés dans la production – pour les conduites d’air utilisées sur les serveurs, par exemple – et disposer également de centres de réparation, de réutilisation et de recyclage afin de réduire l’impact sur l’environnement. Chacun sait que la construction de systèmes complexes implique souvent l’assemblage de technologies de fournisseurs divers. Il est donc tout aussi important de développer une chaîne d’approvisionnement dont tous les acteurs ont les mêmes objectifs environnementaux que l’entreprise elle-même.

Les clients peuvent eux aussi jouer un rôle primordial en choisissant des produits plus respectueux de l’environnement pour leurs data centers. Des outils environnementaux conçus spécialement pour les systèmes d’infrastructure de data center se développent de façon croissante. C’est pourquoi les équipes doivent être vivement encouragées à les utiliser avant de prendre d’importantes décisions technologiques et commerciales. Les évaluations EPEAT (Electronic Product Environmental Assessment Tools), les calculateurs d’empreinte carbone et les calculateurs de coût total de possession (TCO), par exemple, sont d’excellentes ressources. Elles aident le secteur à améliorer sans cesse les caractéristiques environnementales des produits, et elles aident aussi les clients à prendre des décisions éclairées.Des opérations durables commencent par une conception durable

La chaleur est l’un des grands défis du secteur. Il est par conséquent essentiel d’améliorer l’efficacité du refroidissement pour que la consommation électrique du datacenter évite aux systèmes de chauffer. Plus de performance ne veut pas toujours dire plus d’électricité. C’est ce que montrent les technologies de refroidissement qui offrent des performances plus élevées en consommant moins d’énergie. Le refroidissement par eau, par exemple, peut réduire de 40 % les coûts d’énergie du datacenter. Le refroidissement par eau à contact direct élimine jusqu’à 90 % de la chaleur émise par les racks, ce qui baisse de 20 °C la température des processeurs. Ceci permet à ces derniers de tourner en permanence en mode « turbo » et d’accroître ainsi la performance des systèmes. La demande de charge de travail des data centers existants est en constante augmentation, de même que le besoin de densité. Les coûts de refroidissement sont par conséquent en hausse, d’où l’importance de créer des produits plus denses occupant moins d’espace.

Étant donné que l’informatique va devoir répondre à des attentes de performance accrues, la performance par watt de chaque baie du data center va devoir augmenter. Si la performance des processeurs s’est améliorée de façon spectaculaire, la consommation électrique par connecteur a doublé en dix ans, de même que la consommation électrique des serveurs. Il n’est pas rare aujourd’hui qu’un processeur affiche une puissance de ~150-200 W, alors qu’elle n’était que de ~15 W pour le premier processeur Pentium dans les années 1990.

Les fournisseurs de systèmes doivent optimiser l’agencement et la configuration des systèmes, leur gestion thermique et la ventilation des points chauds à l’intérieur des machines. La charge électrique doit en outre être limitée sur les ventilateurs, ainsi que le niveau sonore. Les environnements informatiques classiques sont conçus pour supporter des baies ayant besoin de ~10-15 kW. Ces baies sont généralement refroidies à l’aide de techniques traditionnelles de refroidissement par air. Or, dans les systèmes de machine learning à traitement de données intensif et le calcul haute performance, les baies ont besoin de ~30 kW (voire plus). Ce niveau de puissance implique souvent un refroidissement à l’aide d’un liquide quelconque.

Beaucoup de fournisseurs d’infrastructures de data center utilisent des échangeurs de chaleur locaux avec de l’eau glacée. Cependant, le refroidissement direct par liquide à l’aide d’eau non glacée est une solution beaucoup plus écologique pour limiter l’empreinte carbone du data center. Des organismes de normalisation tels que l’ASHRAE garantissent que le respect des normes permette un fonctionnement fiable. Et les systèmes fiables bien conçus garantissent, eux, qu’une puissance de calcul accrue n’implique pas des accroissements non linéaires des besoins de refroidissement du data center.Anticiper les évolutions technologiques

Dans un contexte d’innovation technologique très rapide, l’ensemble du secteur doit penser à l’environnement et au monde dans lequel nous vivons. Si la puissance, le refroidissement et les matériaux ont tendance à être les domaines les plus visés, d’autres solutions peuvent être étudiées, comme le refroidissement par eau chaude.

Plus globalement encore, il faut considérer la totalité de la chaîne d’approvisionnement. Du plus petit composant d’un serveur aux processus utilisés pour la fabrication, en passant par les bâtiments abritant des serveurs et des systèmes de stockage et de réseau, tout doit concourir à la protection de la planète.

Les normes du secteur sont essentielles pour assurer une réussite durable, tout comme l’action des consortiums industriels pour suivre le rythme de l’évolution d’un monde basé sur les données, des appareils connectés de l’IoT et de l’intelligence artificielle. Alors que les normes et les consortiums continueront d’évoluer – par exemple, ASHRAE, Energy Star, SPEC, EPEAT, Green Grid et LEED –, charge aux acteurs du secteur d’aller encore plus loin dans ce domaine pour préserver nos ressources naturelles.

Et de proposer des nouveautés et des innovations pour réduire l’impact environnemental.

Ce 18 mars 2019, Orange a inauguré son tout nouveau data center, à Anvers. Avec un investissement de près de 14 millions d’euros, ce centre de données hautement sécurisé et éco-efficace de 1400m² est une réponse à la demande croissante d’utilisation mobiles des clients Orange.

Comments are closed, but trackbacks and pingbacks are open.