Un groupe de chercheurs de l’ULiège vient de dévoiler une méthode qui permet aux algorithmes de s’adapter à des situations inconnues… à la manière d’un cerveau humain. Des premiers résultats très prometteurs pour l’avancée de l’IA.

’Intelligence Artificielle (IA) a permis ces dernières années le développement de techniques d’apprentissage automatique très performantes. Cependant, ces techniques sont souvent appliquées tâche par tâche, ce qui implique qu’un agent intelligent entrainé pour une tâche aura de piètres performances sur d’autres tâches, même très similaires. Pour pallier ce problème, des chercheurs de l’Université de Liège (ULiège) ont développé un nouvel algorithme basé sur un mécanisme biologique appelé la neuromodulation. Cet algorithme permet de créer des agents intelligents capables de réaliser des tâches non rencontrées pendant l’entrainement. Ce résultat inédit et exceptionnel est présenté cette semaine dans la revue PLOS ONE.

Arriver à ce que l’intelligence artificielle se rapproche le plus possible du fonctionnement du cerveau humain. Nombreux sont ceux qui évoquent cette possibilité. L’une des premières étapes importantes dans cette direction semble avoir été franchie par une équipe de chercheurs de l’Université de Liège, dont fait notamment partie Damien Ernst, figure bien connue dans le domaine énergétique en Wallonie. Ils viennent, en effet, de dévoiler dans la revue scientifique PLOS One une nouvelle méthode d’intelligence artificielle inspirée du fonctionnement du cerveau humain.

Jusqu’ici, les algorithmes sont entraînés pour réaliser, mieux que les humains, certaines tâches bien spécifiques, comme la reconnaissance d’images. Habitués à voir des images, ils sont capables de détecter des éléments bien spécifiques (par exemple les tumeurs, en imagerie médicale) ou de reconnaître des formes et des objets. Mais ces algorithmes sont non seulement incapables d’effectuer d’autres tâches mais leurs « leurs performances sont souvent décevantes lorsqu’ils sont mis dans des conditions différentes de celles vécues lors de l’entraînement », précise l’équipe de chercheurs liégeois.

Des algorithmes capables de s’adapter eux-mêmes

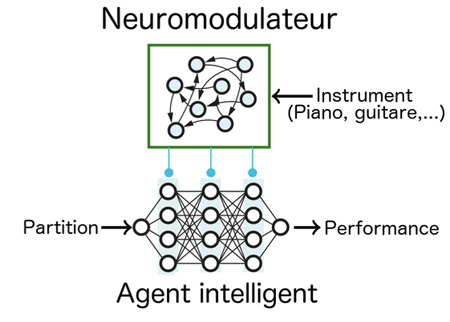

Ces derniers ont dès lors mis au point une nouvelle architecture qui, pour faire simple, introduit des principes biologiques dans des réseaux neuronaux. Concrètement, grâce à deux sous-réseaux de neurones, cela permet aux algorithmes de réaliser des tâches non rencontrées pendant leur entraînement. « Un robot qui aurait été entraîné à reconnaître des chiffres dans une base de données ‘images’ pourrait ensuite reconnaître des lettres, clarifie Nicolas Vecoven, ingénieur doctorant à l’ULiège. Pour autant que les tâches se ressemblent, même si elles sont différentes, l’intelligence artificielle pourra s’en sortir. Un peu comme un humain qui, parce qu’il sait jouer du piano, arrive aussi à jouer de la guitare. »

Cette découverte, mise au point après plus de deux ans de recherches, constitue la première étape d’une vision bien plus long terme de l’équipe liégeoise. « La vision est d’améliorer les algorithmes d’intelligence artificielle sur base des principes de biologie, glisse le doctorant. Cela passe par l’introduction de mécanismes biologiques du cerveau humain dans l’intelligence artificielle. »

Cette découverte qui pourrait faire du bruit dans le microcosme mondial de la recherche en intelligence artificielle reste de la recherche fondamentale. Il n’y a pas encore d’applications concrètes ni de spin-off en vue. Mais l’équipe de chercheurs pourrait s’étoffer dans les mois qui viennent pour continuer ses recherches et susciter des évolutions applicatives.

Source : https://trends.levif.be/

Des chercheurs de l’ULiège créent une nouvelle méthode d’Intelligence Artificielle

Malgré les immenses progrès dans le domaine de l’IA ces dernières années, nous sommes encore très éloignés de l’intelligence humaine. En effet, si les techniques d’IA actuelles permettent d’entrainer des agents informatiques à effectuer certaines tâches mieux que des humains lorsqu’ils sont entrainés spécifiquement pour celles-ci, les performances de ces mêmes agents sont souvent fort décevantes lorsqu’ils sont mis dans des conditions (même légèrement) différentes de celles vécues lors de l’entrainement.

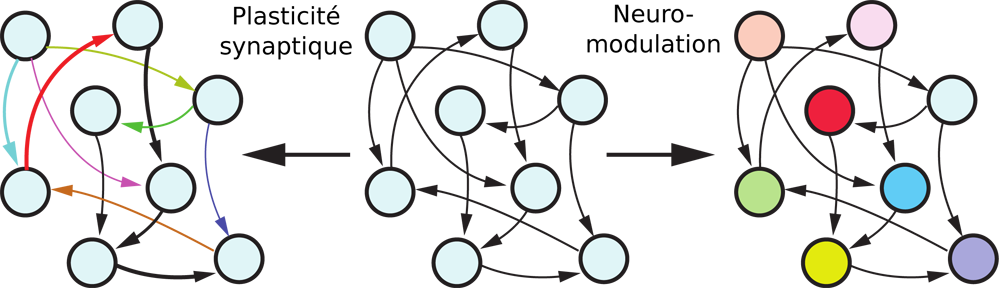

L’être humain est, lui, capable de s’adapter à de nouvelles situations très efficacement en utilisant les compétences qu’il a acquises tout au long de sa vie. Par exemple, un enfant ayant appris à marcher dans un salon saura rapidement marcher également dans un jardin. Dans un tel contexte, l’apprentissage de la marche est associé à la plasticité synaptique qui modifie les connexions entre neurones, tandis que l’adaptation rapide des compétences de marche apprises dans le salon à celles nécessaires pour marcher dans le jardin est associée à la neuromodulation. Celle-ci modifie les propriétés « entrée-sortie » des neurones eux-mêmes via des neuromodulateurs chimiques.

La plasticité synaptique est à la base de toutes les dernières avancées dans le domaine de l’IA. Cependant aucun travail scientifique n’avait proposé jusqu’à aujourd’hui une manière d’introduire un mécanisme de neuromodulation dans des réseaux de neurones artificiels. Ce résultat tout à fait exceptionnel, décrit cette semaine dans la revue PLOS ONE, est issu d’une collaboration très fructueuse entre des chercheurs en neurosciences et des chercheurs en intelligence artificielle de l’Université de Liège mettant au point des algorithmes intelligents : deux doctorants, Nicolas Vecoven et Antoine Wehenkel, ainsi que deux professeurs, Damien Ernst (spécialiste en intelligence artificielle) et Guillaume Drion (neuroscientifique).

Ces chercheurs de l’ULiège ont développé une architecture de réseaux de neurones artificiels tout à fait originale, introduisant une interaction entre deux sous-réseaux. Un premier prend en compte toutes les informations contextuelles concernant la tâche à résoudre et, sur la base de ces dernières, neuromodule le deuxième sous-réseau à la manière des neuromodulateurs chimiques du cerveau. Grâce à la neuromodulation, ce deuxième sous-réseau, déterminant les actions que l’agent intelligent doit effectuer, peut donc être adapté très rapidement en fonction de la tâche courante. Cela permet à l’agent de résoudre efficacement de nouvelles tâches.

Cette architecture novatrice a été testée avec succès sur des classes de problèmes de navigation pour lesquels l’adaptation est nécessaire. Des agents entrainés à se déplacer vers une cible, tout en évitant des obstacles, ont notamment été capables de s’adapter à des situations dans lesquelles leur mouvement était perturbé par du vent dont la direction est extrêmement variable.

Pr Damien Ernst : « La nouveauté de cette recherche est que, pour la première fois, des mécanismes cognitifs identifiés en neurosciences trouvent des applications algorithmiques dans un contexte multi-tâches. Cette recherche ouvre des perspectives dans l’exploitation en IA de la neuromodulation, mécanisme-clé du fonctionnement du cerveau humain. »

L’intelligence artificielle va-t-elle dépasser l’intelligence humaine?

Charles Hadji — 8 septembre 2019

L’intelligence artificielle (IA) accomplit des progrès fulgurants. Elle change en profondeur le monde de la justice, avec l’émergence d’une «justice prédictive». Les robots chirurgicaux font des prodiges, qui pourraient conduire à des ruptures majeures dans les techniques médicales. L’IA serait-elle sur le point de surpasser l’intelligence humaine ou biologique (IB)?

C’est la thèse que défendait, dès 2017, le Dr Laurent Alexandre dans son ouvrage La guerre des intelligences, à qui son succès vient de valoir une nouvelle édition en livre de poche. Sa lecture nous offre l’opportunité de réfléchir, à travers la question de l’intelligence, à la spécificité et à l’avenir de l’humanité. Celle-ci est-elle à un tournant décisif qui pourrait la voir disparaître?

Un face-à-face mortifère?

Pour Laurent Alexandre, la «révolution NBIC» (nanotechnologies, biotechnologies, informatique et sciences cognitives) se traduit par l’émergence d’une IA qui, ouvrant «des perspectives extraordinaires», se trouve d’ores et déjà en position de surpasser l’IB, voire de la réduire en esclavage. La machine pourrait triompher de l’être humain.

Mais pourquoi imaginer et craindre un conflit, qui plus est meurtrier? IA et IB sont-elles concurrentes, et ont-elles des intérêts contraires? L’IA ne pourrait avoir la velléité d’entrer en guerre contre l’IB que si deux conditions sont remplies: qu’elle se révèle plus performante que l’IB et qu’elle ait conscience de sa supériorité. Autrement dit: qu’elle soit dotée d’un pouvoir de décision, qui serait la marque d’une réelle autonomie, et d’une véritable conscience.

La première condition paraît remplie. «Le tsunami de l’IA» va déjà «trop vite et trop haut», estime Laurent Alexandre. «Le neurone perd chaque jour plus de points devant le transistor.» Dans la course à la productivité et à l’efficacité, «la rapidité et l’infaillibilité d’exécution des machines intelligentes» sont de nature à rendre «absolument non compétitif le travail humain». Le combat est ici inégal. L’IA «galope», tandis que l’IB piétine, dans l’attente d’une hypothétique mutation génétique. Une diligence ne peut lutter contre le TGV.

Une «singularité» bien hypothétique

Mais qu’en est-il de la seconde condition? Alexandre écrit que «l’IA pourrait devenir supérieure à l’humanité», pour qui elle prend «des allures de crépuscule». Ce qui fait la supériorité actuelle (bien qu’en grand péril?) de l’humanité est l’existence d’une volonté consciente. Même s’ils ne sont pas toujours bons, l’être humain est capable de faire des choix, de se doter de buts, et de se poser la question de la valeur de ceux-ci.

L’IA peut-elle être dotée (pire: se doter?) d’une telle capacité? Peut-elle devenir capable de réflexion, éthique et politique? C’est toute la question de la «singularité», «ce moment où l’intelligence des machines dépassera celle des hommes». Un tel moment est-il inéluctable? Est-il autre chose qu’une simple vue de l’esprit? Peut-on vraiment faire l’hypothèse d’une «IA forte», qui «aurait la capacité de cacher ses propres buts», et donc, déjà, d’en avoir?

Si l’intelligence biologique est limitée et faillible, du moins s’accompagne-t-elle de cette conscience de soi et de cette capacité de réflexion critique, que l’on ne pourrait attribuer à l’IA que par un tour de magie, semblable à celui qui fait du pantin Pinocchio un véritable être humain.

La croyance en un possible «basculement dans un monde où les robots seraient aussi intelligents que l’homme» témoigne d’une conception réductrice de l’intelligence, limitée à la «puissance de calcul»; et manifeste une crédulité enfantine devant une fable digne de Carlo Collodi. Comment croire sérieusement que l’IB puisse être le Geppetto donnant naissance à une IA dotée de «volonté libre» et de «conscience artificielle»?

L’IA peut-elle être dotée (pire: se doter?) d’une telle capacité? Peut-elle devenir capable de réflexion, éthique et politique? C’est toute la question de la «singularité», «ce moment où l’intelligence des machines dépassera celle des hommes». Un tel moment est-il inéluctable? Est-il autre chose qu’une simple vue de l’esprit? Peut-on vraiment faire l’hypothèse d’une «IA forte», qui «aurait la capacité de cacher ses propres buts», et donc, déjà, d’en avoir?

Si l’intelligence biologique est limitée et faillible, du moins s’accompagne-t-elle de cette conscience de soi et de cette capacité de réflexion critique, que l’on ne pourrait attribuer à l’IA que par un tour de magie, semblable à celui qui fait du pantin Pinocchio un véritable être humain.

La croyance en un possible «basculement dans un monde où les robots seraient aussi intelligents que l’homme» témoigne d’une conception réductrice de l’intelligence, limitée à la «puissance de calcul»; et manifeste une crédulité enfantine devant une fable digne de Carlo Collodi. Comment croire sérieusement que l’IB puisse être le Geppetto donnant naissance à une IA dotée de «volonté libre» et de «conscience artificielle»?

Mais tel est alors sans doute, précisément, le véritable enjeu. L’IA nous met au défi de faire nos preuves en humanité! Où est l’essentiel, qu’il nous faudrait préserver de toutes nos forces? À travers la question de l’intelligence, c’est bien celle de la spécificité humaine qui est posée. «Que voulons-nous en tant qu’êtres humains? Avons-nous une spécificité à faire valoir?»

Finalement, où est l’ennemi?

Laurent Alexandre suggère de «sanctuariser quelques lignes rouges qui fondent notre humanité». Il voit pour celle-ci trois piliers: le corps physique, l’esprit individuel et le hasard. Ce qui lui permet de conclure, de façon optimiste: «Non, l’intelligence biologique ne mourra pas avec l’IA.»

Pour cela, nous ajouterions volontiers une condition: qu’elle sache quel est son véritable ennemi, et où il se cache. Car la crainte des méfaits d’une «IA forte» est le fruit d’une externalisation de nos terreurs. Nous craignons un ennemi extérieur, alors que, comme Paul Valéry nous en avait prévenus, le véritable ennemi est en nous.

«Le vrai rongeur, le ver irréfutable

N’est point pour vous qui dormez sous la table,

Il vit de vie, il ne me quitte pas!»

Le plus grand ennemi de l’intelligence humaine, et donc, finalement, de l’humanité, est tapi en l’être humain. Il porte un nom: la bêtise. Ou, pour le dire encore plus clairement, sauf le respect que l’on doit au lectorat: la connerie…

Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original.

Comments are closed, but trackbacks and pingbacks are open.